„Kolleginnen und Kollegen aus der Neurowissenschaft meinen, dass wir heute im Grunde weniger über die Funktionsweise des menschlichen Gehirns wissen als noch vor zehn Jahren“, sagt Wolfgang Maass. Der Informatiker hat sich in seiner Arbeit darauf spezialisiert herauszufinden, wie das Rechenzentrum in unseren Köpfen Informationen verarbeitet und wie diese Funktionsweise für die Anwendung in Computern genutzt werden könnte. Das menschliche Hirn ist ein komplexes, überaus effizientes und leistungsstarkes Organ zur Informationsverarbeitung. Da es gleichzeitig mit rund einer Million Mal weniger Energie als ein Supercomputer auskommt – trotz einer in etwas gleich großen Anzahl von Rechenelementen –, wird es auch vonseiten der Industrie seit einigen Jahren intensiv beforscht.

Kolleginnen und Kollegen aus der Neurowissenschaft meinen, dass wir heute im Grunde weniger über die Funktionsweise des menschlichen Gehirns wissen als noch vor zehn Jahren.

Ein weiteres Motiv ist das Auslaufen von Moore’s Law: „Es wird intensiv diskutiert, ob unsere derzeit gängigen Computerarchitekturen tatsächlich an die Grenzen ihrer Leistungsfähigkeit stoßen“, erklärt Maass. „Einigkeit herrscht aber darüber, dass man neue Arten finden sollte, Computer zu bauen, um ihre Leistung noch weiter steigern zu können.“ 2013 startete die Europäische Union mit dem Human Brain Project einen europaumspannenden Forschungsverbund, der sich zum Ziel gesetzt hat, die Forschung rund um das menschliche Gehirn zu fördern, Forschungsinfrastruktur aufzubauen und das gesammelte Wissen für den Bau von neuen Rechnerarchitekturen zu nutzen. Heute steht das auf zehn Jahre anberaumte Projekt ungefähr auf Halbzeit. Wolfgang Maass und sein Team sind im Human Brain Project für das Arbeitspaket Computation Principles verantwortlich. Sie haben sich zur Aufgabe gesetzt, die Informationsverarbeitung im Gehirn zu untersuchen und Wege zu finden, die daraus gewonnenen Erkenntnisse für die Entwicklung neuer Computerarchitekturen einzusetzen. „Und das erfordert viel Innovation“, erklärt Maass. „Das menschliche Gehirn arbeitet vollkommen anders, als es alle uns bekannten Schaltkreise tun.“

Im Human Brain Project arbeitet man an der Entschlüsselung des menschlichen Gehirns.

Gehirn vs. Computer

Heute bekannte Computersysteme arbeiten nach dem Turing-Prinzip: ein universelles, aber fixes Rechenprinzip, mit dem alle möglichen Anwendungen bearbeitet werden können. „Das war damals das Revolutionäre an dem System von Turing: Man brauchte nicht für jede Anwendung einen neuen Computer, sondern hatte ein System, das universell einsetzbar ist“, erzählt Maass. Unser Gehirn hingegen arbeitet gänzlich anders: „Im Gegensatz zu Computern arbeitet das Hirn zum Beispiel nicht mit Bits – also abstrakten Informationseinheiten –, sondern mit Spikes – also kurzen Spannungserhöhungen als raum-zeitlichen Ereignissen–, um Informationen zu kodieren und zu verarbeiten“, erklärt Maass. „Aber Spikes von verschiedenen Neuronen haben nicht das gleiche ‚Gewicht’ bei dieser Verarbeitung. Man muss sich das ein bisschen wie zwischenmenschliche Kommunikation vorstellen: Wir nehmen die Meinung einiger Personen ernster als die von anderen Personen.“

Brain-inspired Computing

Derzeit arbeitet das Team rund um den Wissenschafter an einer Simulation, die die Arbeitsweise von Schaltkreisen des Gehirns nachbildet. „Man darf nicht vergessen, dass die Evolution für dieses komplexe Organ verantwortlich ist und es ohne einen klaren Bauplan oder klare Prinzipien entstanden ist“, mahnt Maass. Deshalb arbeitet sein Team daran, leistungsfähige Neuronennetzwerke durch eine im Computer simulierte Evolution zu erzeugen. Dabei sind neue Deep-Learning-Methoden sehr nützlich, die man für diese Aufgabe umprogrammiert hat. Die Erkenntnisse, die aus der Analyse der dadurch erzeugten Netzwerke gewonnen werden, sind faszinierend: „Sie können um vieles effizienter und robuster mit Spikes Information verarbeiten als alle Netzwerke, die wir bisher kennen.“

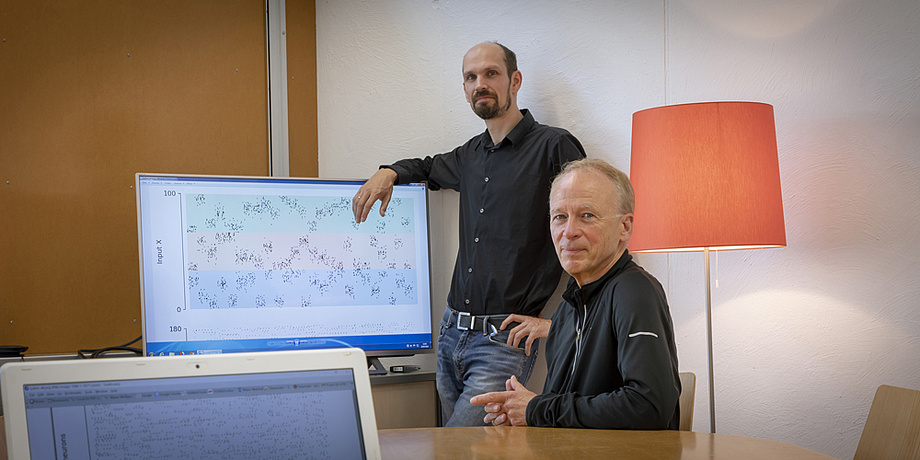

Das Team des Instituts für Grundlagen der Informationsverarbeitung.

Synaptische Plastizität und Lernen

Robert Legenstein arbeitet ebenfalls am Institut für Grundlagen der Informationsverarbeitung an der Erforschung neuronaler Prozesse. Ein Schwerpunkt seiner Forschung ist synaptische Plastizität und ihre Rolle in Lernprozessen. Synapsen sind die Kommunikationskanäle im Gehirn, über die Neurone mittels Spikes Informationen austauschen. Die Änderung der Eigenschaften dieser Kanäle wird als synaptische Plastizität bezeichnet. „Eine überraschende Erkenntnis ist, dass sich das Gehirn ständig verändert, auch wenn man eigentlich gerade gar nichts lernt. Verbindungen zwischen Neuronen entstehen und verschwinden wieder. Das Gehirn ist ständig in Bewegung – ganz anders als herkömmliche Computer, bei denen die Schaltkreise von vornherein festgelegt und starr sind“, beschreibt der Forscher.

Das Gehirn ist ständig in Bewegung – ganz anders als herkömmliche Computer, bei denen die Schaltkreise von vornherein festgelegt und starr sind.

„Unser Gehirn arbeitet also nicht in festgelegten Bahnen, sondern die Verbindungsstruktur der Neurone fluktuiert ständig – und diese Fluktuation wird nur stärker, wenn man etwas lernt.“ Eine mögliche Erklärung für diese permanente Veränderung ist das Streben nach einer Struktur, die optimal an die Lebensumstände des Organismus angepasst ist. Vereinfacht gesprochen: Nicht benötigte Verbindungen werden entfernt, neue werden zufällig eingeführt und verstärkt, wenn sie sich als nützlich erweisen. In mathematischen Modellen und Simulationen bilden die Forschenden solche Verbindungsfluktuationen im Gehirn nach. „Unsere Simulationen und theoretischen Analysen bestätigen, dass dieses Prinzip tatsächlich eine gezielte Suche nach optimalen Verbindungsstrukturen implementiert“, sagt Legenstein. Diese Erkenntnisse können auch im Bereich des Deep Learnings genutzt werden. Das Team rund um Legenstein entwickelte daraus einen Lernalgorithmus für künstliche neuronale Netzwerke, der mit bis zu 50-mal weniger Verbindungen auskommt als üblich. Durch die Einsparung von Verbindungen wird das Training schneller, effizienter und benötigt weniger Speicherplatz und Energie.

Das Modell von Verbindungsfluktuationen im Gehirn wird in einem wissenschaftlichen Paper beschrieben, das kürzlich in eNeuro veröffentlicht wurde. Das vollständige Paper kann auf der Website des Magazins eingesehen werden.

Die Funktionsweise des daraus entwickelten Lernalgorithmus wurde kürzlich auf der International Conference on Learning Representations (ICLR) präsentiert. Das Paper dazu gibt es auf der Konferenz-Website.

Ausprobiert wird der Algorithmus derzeit in Kooperation mit der TU Dresden an dem von ihr entwickelten Spinnaker 2- Chip. Auf dem Chip wurde ein künstliches neuronales Netzwerk implementiert, das darauf trainiert wurde, handgeschriebene Ziffern zu erkennen. Durch den Lernalgorithmus konnte der Speicherbedarf beim Training um den Faktor 30 reduziert werden. Verglicht man die Leistungsaufnahme des Spinnaker 2-Chips mit der eines herkömmlichen Computers, so zeigt sich der Vorteil dieses Systems: Während der Computer 20 Watt während des Trainings des Netzwerkes benötigt, kommt der Spinnaker 2-Chip durch den Lernalgorithmus mit nur 88 Milliwatt aus.

Wird man das menschliche Gehirn bald entschlüsselt haben?

Auf diese Frage geben die beiden Forschenden eine ganz eindeutige Antwort: „Es wird wohl noch lange dauern.“ Denn das menschliche Gehirn ist nach wie vor eines der kompliziertesten, aber auch faszinierendsten Forschungsgebiete. Und jeder neue Forschungsschritt nach vorne gibt Wissenschafterinnen und Wissenschaftern neue Rätsel auf, deren Lösungen auch weiterhin gesucht werden.

Dieses Forschungsgebiet ist im FoE „Information, Communication & Computing“ verankert, einem der fünf Stärkefelder der TU Graz.

Mehr Forschungsnews aus diesen Bereichen finden Sie auf Planet research.